在當今大數據時代,MongoDB以其靈活的文檔模型、強大的橫向擴展能力和高性能,成為處理海量數據的流行選擇。當數據量達到上億甚至數十億級別時,系統的性能、穩定性和擴展性將面臨嚴峻考驗。此時,合理的計算機硬件與網絡設備配置,不再是簡單的資源堆砌,而是決定系統成敗的關鍵工程決策。本文將深入探討在此場景下的核心配置考量。

一、 計算機硬件配置策略

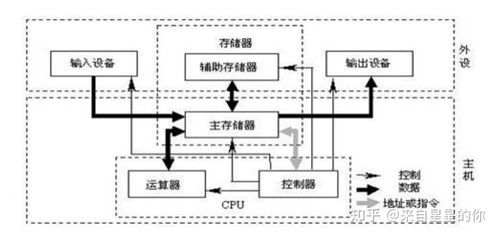

處理上億級數據的MongoDB集群,其硬件配置需圍繞I/O、內存、CPU和存儲四大核心展開。

1. 存儲子系統:速度與容量的平衡

* 硬盤類型:必須使用固態硬盤。機械硬盤的隨機I/O性能無法滿足高并發讀寫需求,是性能的最大瓶頸。推薦使用企業級NVMe SSD,以獲得極低的延遲和極高的IOPS。

- 存儲配置:強烈建議將數據存儲、日志存儲和操作系統分置于不同的物理磁盤或邏輯卷上,避免I/O爭用。對于WiredTiger存儲引擎,其數據壓縮特性可節省空間,但計算本身會消耗少量CPU。

- RAID級別:通常采用RAID 10,它在提供出色讀寫性能的通過鏡像保障了數據安全。避免使用RAID 5/6,因其寫入性能較差。

2. 內存:越大越好,但需精打細算

* 工作集原則:內存容量應盡可能覆蓋“工作數據集”——即經常被訪問的熱數據。對于上億條文檔,即使經過索引,工作集也可能達到數百GB。內存不足將導致頻繁的磁盤換入換出,性能急劇下降。

- 分配策略:為MongoDB進程分配充足內存,同時為操作系統文件緩存預留空間(通常占物理內存的20%-30%)。監控

wiredTiger cache的命中率是評估內存是否充足的關鍵指標。

3. CPU:多核與高主頻并重

* 多核并行:MongoDB的查詢、聚合、索引構建及復制集同步等操作都能利用多核。建議選擇核心數較多的CPU(如16核以上)。

- 時鐘頻率:更高的主頻對單線程操作(如某些聚合管道階段)有益。需根據實際負載特點(是大量簡單查詢還是復雜分析)在核心數與主頻間取得平衡。

4. 網絡接口:每臺服務器應配備萬兆(10GbE)或更高速率的網絡接口卡。集群內部節點間(分片間、副本集成員間)的數據同步、心跳檢測、查詢路由(mongos)會產生巨大的網絡流量,千兆網絡極易成為瓶頸。

二、 網絡設備與架構設計

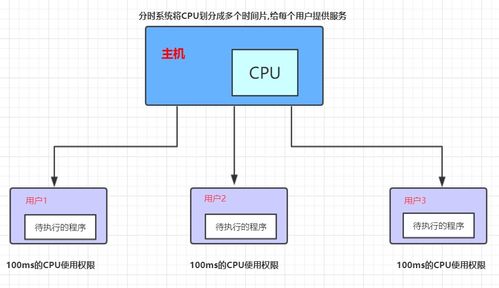

強大的單機是基礎,但上億級數據必然依賴分片集群。此時,網絡成為連接各個“器官”的“血管系統”。

1. 網絡拓撲與延遲

* 低延遲需求:所有MongoDB集群組件(配置服務器、分片節點、mongos路由器)應部署在同一低延遲的數據中心或可用區內。跨地域部署會引入顯著網絡延遲,嚴重影響寫關注、讀偏好和平衡器操作。

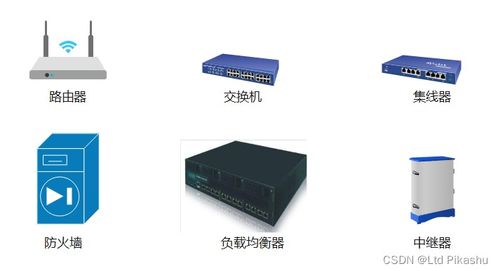

- 網絡隔離與安全:使用VLAN或私有子網對MongoDB集群流量進行隔離,確保數據同步和內部通信的安全與穩定。通過防火墻嚴格限制訪問源。

2. 網絡設備要求

* 交換機性能:核心交換機和接入交換機必須支持全線速萬兆轉發,且具有足夠的背板帶寬和包轉發率,以應對集群內部突發的大流量數據遷移(塊遷移)和同步。

- 冗余與高可用:采用鏈路聚合和設備堆疊/集群技術,實現網絡路徑的冗余,避免單點故障導致整個數據庫集群不可用。

3. 與應用程序的互聯

* 應用服務器連接:應用程序服務器(或API服務器)連接mongos路由器的網絡同樣需要高帶寬、低延遲。多個mongos實例應實現負載均衡。

- 驅動程序配置:在應用端使用最新版本的官方驅動程序,并合理設置連接池大小、超時和讀寫關注級別,以優化網絡利用效率。

三、 配置原則與監控

核心原則:均衡與留有余量。避免出現CPU極強但I/O極弱,或內存巨大但網絡吞吐不足的“木桶效應”。所有硬件資源應協同工作,并預留20%-30%的峰值處理余量。

持續監控與調優:硬件配置不是一勞永逸的。必須建立完善的監控體系,持續關注關鍵指標:

硬件層:磁盤IOPS/延遲、網絡帶寬/丟包率、CPU負載、內存使用/交換情況。

MongoDB層:操作排隊情況、鎖競爭、緩存命中率、復制延遲、分片塊分布與遷移狀態。

通過監控數據,可以及時發現瓶頸,并進行垂直升級(如增加內存、更換更快SSD)或水平擴展(如增加新的分片節點)。

###

處理上億級數據的MongoDB系統,是一個復雜的系統工程。卓越的硬件與網絡設計,是承載其高效、穩定運行的物理基石。它要求架構師不僅深諳MongoDB的內部原理,更要通曉硬件特性與網絡知識,在性能、成本與可靠性之間做出精準的權衡,從而構建出能夠從容應對海量數據挑戰的堅實數據平臺。